La Tecnología Informática (IT), según lo definido por la asociación de la Tecnología Informática de América (ITAA), es “el estudio, diseño, desarrollo, innovación puesta en práctica, ayuda o gerencia de los sistemas informáticos computarizados, particularmente usos del software y hardware.” En general, se ocupa del uso de computadoras y del software electrónico de convertir, de almacenar, de proteger, de procesar, de transmitir y de recuperar la información.

La Tecnología Informática hoy

Hoy, el término tecnología informática se ha ampliado para abarcar muchos aspectos referidos a la computadora y la tecnología informática. El paraguas de la tecnología informática puede ser grande, cubriendo muchos campos. Los profesionales realizan una variedad de deberes que se extiendan de instalar usos a diseñar redes de ordenadores y bases de datos complejas. Algunos de los deberes que los profesionales, Ingenieros e Ingenieros Técnicos en Informática, realizan pueden incluir:

Una lista más extensa de asuntos relacionados se proporciona abajo. y desarrollar aun mas el mundo de la tecnología

Organizaciones de la industria

La tecnología de la informática del mundo y la alianza de los servicios (WITSA) es un consorcio sobre 60 asociaciones de la industria de la tecnología informática (IT) de economías alrededor del mundo. Fundado adentro 1978 y conocido originalmente como la asociación de la industria de servicios del mundo que computaba, WITSA ha asumido cada vez más un papel activo de la defensa en las ediciones internacionales del orden público que afectaban la creación de una infraestructura de datos global robusta.

La asociación de la tecnología informática de América (ITAA) es un grupo comercial de la industria para varias compañías de la tecnología informática de los EE.UU.

Fundado en 1961 como la asociación de las organizaciones de servicios de proceso de datos (ADAPSO), la asociación de la tecnología informática de América (ITAA) proporciona el orden público global, el establecimiento de una red del negocio, y la dirección nacional para promover el crecimiento rápido continuado del IT industrial. ITAA consiste en nn nnnnnnnnnnn aproximadamente 325 miembros corporativos a través de los EE.UU., y es secretaría de la tecnología informática del mundo y mantiene la alianza (WITSA), una red global d e IT de los 67 países asociados.

Tecnología de la informática accesible en la educación y temas relacionados

Translations of September 2003 documents were performed by the Great Lakes ADA & Accessible IT Center in collaboration with the Northeast ADA & IT Center under NIDRR grant #H133D10205.

La tecnología se ha convertido en parte integral de la mayoría de entidades educativas, pero aun así muchas personas todavía encuentran confusa la terminología sobre el tema. Las siguientes definiciones tratarán de aclarar parte de la confusión, explicando los términos más comunes en la forma simple y sin el uso de un lenguaje técnico. Esperamos que este documento sea fácil de entender para cualquier persona que trabaje con tecnología en el campo educativo, incluyendo profesores, personal de tecnología de informática, lideres políticos, directores de programas de informática en escuelas, personal de enseñanza a distancia y diseñadores de páginas electrónicas. Este documento no ofrece definiciones legales completas, pero incluye al final las fuentes donde usted puede obtener más información.

¿Qué es la tecnología de informática?

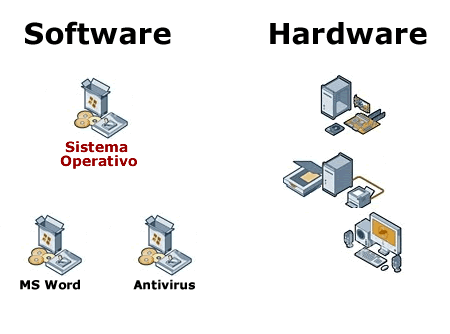

La tecnología de informática (TI) incluye los productos que almacenan, procesan, transmiten, convierten, copian o reciben información electrónica. En la legislación federal el término tecnología electrónica y de informática (E&IT) es el que normalmente se utiliza. Ejemplos de IT pueden ser: programas para aplicaciones especificas, sistemas operacionales, sistemas de informática y aplicaciones basadas en la red, teléfonos y otros medios de telecomunicación, aparatos de video, productos de multi-media, y equipos de oficina. Los textos electrónicos, programas de instrucción, correo electrónico, programas para intercambiar conversaciones en línea y programas de enseñanza a distancia son también considerados ejemplos de tecnología de informática.

¿Qué es la tecnología de asistencia?

La tecnología de asistencia se refiere a los productos utilizados por personas con discapacidades para lograr acceso al medio ambiente y actividades que de otra forma serian difíciles o imposibles de utilizar. Permite que las personas puedan llevar a cabo las tareas cotidianas de la vida regular, como vestirse o comer, facilitar la comunicación y les ofrece mayor acceso a la educación, al empleo y a la diversión. Ejemplos de la tecnología de asistencia son: las sillas de ruedas, controles manuales para manejar vehículos y los aparatos de ayuda para limitaciones del habla o del oído.

Los productos de asistencia específicamente relacionados con TI accesible (conocidos como tecnología adaptada) son aquellos que le permiten a personas con discapacidades operar computadoras, programas, el Internet, teléfonos y otra tipo de tecnología de informática. Si una persona tiene uso limitado de las manos y quiere manejar una computadora, puede utilizar un teclado con teclas más grandes, o un ratón (mouse) especial; las personas ciegas o con dificultades para leer pueden utilizar programas que anuncian en voz alta el texto en la pantalla; las personas con limitación de la vista pueden utilizar programas de magnificación de pantalla. Las personas con dificultades auditivas o sordas pueden utilizar los sistemas telefónicos TTY/ o teléfono de texto para comunicarse por teléfono; personas con limitaciones del habla pueden utilizar un aparato que anuncia en voz alta el texto lo que la persona escribe usando un teclado.

¿Que es el diseño universal?

Para aplicar un diseño universal significa desarrollar productos que toda persona pueda utilizar al máximo posible sin necesidad de ser adaptado o de tener un diseño especial. Estos productos ayudan a una gran variedad de personas con diferentes preferencias y habilidades individuales; comunicar adecuadamente la información (sin tener en cuenta las condiciones ambientales o las habilidades sensoriales de los usuarios) y estos productos pueden ser encontrados, obtenidos, manipulados y utilizados sin tener en cuenta el tamaño físico, la condición física, o la capacidad de desplazamiento de la persona. Al aplicarse los principios del diseño universal, se reduce la necesidad de la tecnología de asistencia, que resulta en un producto compatible con esta tecnología creando un producto que funciona mejor para todos y no sólo para las personas discapacitadas.

¿Qué puede hacer que la tecnología de informática no sea accesible a las personas con discapacidades?

La TI puede considerarse no accesible a las personas con discapacidades si solo le ofrece al usuario una única forma de acceso, para manipular la información, sobre todo si la habilidad de utilizar esta tecnología depende primordialmente del uso de la vista o el oído. Por ejemplo, las personas con limitaciones de la vista no pueden leer instrucciones presentadas solamente en un formato visual; las personas sordas no pueden entender el contenido presentado únicamente en forma oral; las personas que no ven colores no pueden diferenciar entre opciones mostradas en diferentes colores; las personas con uso limitado de las manos no pueden utilizar el ratón (mouse) en la computadora; y las personas que se movilizan por medio de la silla de ruedas no pueden utilizar una maquina de fax que tiene los controles en un sitio imposible de alcanzar, mientras esta persona permanece sentada. Las páginas electrónicas con diseños sin concordancia, que usan gráficos difíciles de reconocer y utilizan un lenguaje no accesible, son difíciles de usar para todos, sobre todo las personas con limitaciones cognoscitivas y las que tienen dificultad para leer. Muchas de estas barreras pueden ser reducidas o eliminadas cuando la tecnología se desarrolla usando un diseño universal.

¿Que es la tecnología de informática accesible?

La TI (Tecnología de Informática) accesible es compatible con la tecnología de asistencia, e incluye ciertas características flexibles que permiten a las personas con discapacidades utilizar la tecnología de asistencia. Características relacionadas con la accesibilidad pueden ser incluidas desde un principio, como en el caso de una respuesta auditiva en los quioscos informativos o ser una opción de alto contraste en los programas operacionales de computadoras. También se puede hacer una orden especial, como por ejemplo haciendo uso de subtítulos o de descripciones orales en el video. En principio, el término accesibilidad implica que las personas puedan interactuar con la tecnología de la mejor forma posible de acuerdo a cada caso. En la práctica, la determinación de lo que puede o no ser realmente accesible se considera un tema técnico complejo. Los niveles de calidad de la Sección 508, desarrollados por el Comité sobre el acceso determinan los niveles mínimos de calidad con relación a la accesibilidad. Para mayor información usted se puede dirigir a la página en la Internet:

www.section508.gov

Ejemplos sobre la Tecnología de Informática (TI) accesible en la educación

Aplicaciones accesibles a programas pueden pcional que tas características diseñadas o presentado en la pantalla, se permite la participación completa e independiente de los estudiantes con limitaciones cognoscitivas y con problemas para leer. Se pueden ofrecer audífonos para evitar que esto distraiga a los otros compañeros.

Videos accesibles

Los videos accesibles ofrecen subtítulos sincronizados para toda información verbal, así como todo contenido presentado en el formato de audio. También se ofrecen las descripciones verbales sincronizadas para explicar el contenido visual.

Páginas electrónicas accesibles

Las páginas electrónicas accesibles han sido diseñadas para garantizar que toda persona que la visite pueda movilizarse dentro de ella, tenga acceso a su contenido, y participe en actividades interactivas de la red. Las páginas electrónicas accesibles ofrecen un texto equivalente (generalmente una descripción) para todos los elementos que no son de texto, como de audio, video, gráficos, animación, botones gráficos, y mapas de imágenes. Además ofrecen un sistema de navegación claro y sin contradicciones y siguen de cercaniños con limitaciones visuales y los que tienen uso limitado de las manos los puedan usar.

Piense en un estudiante tomando un examen usando una computadora. Las instrucciones y preguntas aparecen en forma de texto en la pantalla. Al incluirse una función opcional que permite leer en voz alta el texto presentado en la pantalla, se permite la participación completa e independiente de los estudiantes con limitaciones cognoscitivas y con problemas para leer. Se pueden ofrecer audífonos para evitar que esto distraiga a los otros compañeros.

Videos accesibles

Los videos accesibles ofrecen subtítulos sincronizados para toda información verbal, así como todo contenido presentado en el formato de audio. También se ofrecen las descripciones verbales sincronizadas para explicar el contenido visual.

Páginas electrónicas accesibles

Las páginas electrónicas accesibles han sido diseñadas para garantizar que toda persona que la visite pueda movilizarse dentro de ella, tenga acceso a su contenido, y participe en actividades interactivas de la red. Las páginas electrónicas accesibles ofrecen un texto equivalente (generalmente una descripción) para todos los elementos que no son de texto, como de audio, video, gráficos, animación, botones gráficos, y mapas de imágenes. Además ofrecen un sistema de navegación claro y sin contradicciones y siguen de cerca las normas más importantes de la accesibilidad en términos de su contenido, como las directrices publicadas bajo la iniciativa para la accesibilidad en la red del World Wide Web Consortium (WAI) o de la Sección 508. Las páginas electrónicas diseñadas de esta manera permiten que las personas que no pueden leer la pantalla puedan tener acceso a la información, usando la tecnología de asistencia por ejemplo un lector de pantalla. Recuerde que aunque un lector electrónico de pantalla puede leer la descripción de una foto, el lector de pantalla mas sofisticado no puede ofrecer una descripción a menos que esta haya sido previamente programada.

Máquinas foto-copiadoras accesibles

Una máquina foto-copiadora accesible puede ser operada de más de una forma por medio de teclas, pantallas táctiles, o un sistema de reconocimiento de voz. La altura y posición también puede ser ajustadas para garantizar que se puedan alcanzar los controles y que se puedan ver las pantallas con facilidad. Las ranuras para introducir los documentos deben estar situadas al mismo nivel del escritorio para que las puedan alcanzar fácilmente las personas en sillas de ruedas.

Trabajando hacia la creación de ambientes accesibles

Los mismos principios sobre la creación de los ambientes físicos accesibles se usan en la creación de los ambientes accesibles de la TI. En la misma forma que los edificios con rampas y elevadores se consideran más accesibles para personas que usan sillas de ruedas, la Tecnología Informática que obedece los requisitos del diseño accesible es más útil para personas con gran variedad de habilidades y discapacidades. En pocas palabras, la TI crea medios ambientes educativos virtuales accesibles. De la misma forma que todos los elementos físicos de un edificio escolar deben ser accesibles (baños, bibliotecas, cafetería), todas las especificaciones de la escuela virtual también deben ser accesibles (página electrónica, enciclopedia en CD-ROM, intercambios de opiniones en línea, y evaluaciones.)

La creación de sistemas de informática accesibles utilizados en establecimientos y programas requieren una planeación previa. Por ejemplo, al preparar un programa de enseñanza a distancia, los diseñadores no pueden anticipar con certeza las posibles discapacidades de los futuros estudiantes. Al aplicar los principios del diseño universal, pueden asegurarse que toda persona, incluyendo los discapacitados, puedan también utilizar los sistemas. Los productos de multimedia necesitan usar subtítulos y descripciones verbales; los recursos de las páginas electrónicas deben ser diseñados tomando en cuenta la accesibilidad, para garantizar que las personas que utilizan diferentes formas de tecnología de asistencia también puedan utilizarlas; la comunicación en el salón de clase debe llevarse a cabo a través de una tecnología accesible para todos y se deben establecer planes para ofrecer acomodaciones especificas de acuerdo con la discapacidad de la persona, si éstas son requeridas. Ofrecer un curso de enseñanza a distancia que no sea accesible seria igual que ofrecer una clase en un edificio sin rampas o elevadores. Aun cuando un estudiante utilice una silla de ruedas para movilizarse, él o ella no va a poder llegar a la clase. Aunque se pueden hacer modificaciones a estructuras ya existentes en ambientes físicos o electrónicos, ésto puede ser bastante costoso, no siempre es una solución aceptable y puede tomar demasiado tiempo.

Los ambientes de TI accesibles también tienen sentido en términos financieros. Algunos beneficios de los ambientes de la TI accesible permiten que toda persona en la comunidad pueda participar en una actividad escolar, reduce la necesidad (y por lo tanto el costo total) de las acomodaciones especiales y reducen o eliminan el riesgo de quejas y posibles juicios legales costosos. Las organizaciones que valoran y promueven el desarrollo de ambientes accesibles en la TI crean sistemas que son más accesibles y que todos pueden utilizar.